Alătură-te evenimentului în care liderii companiilor au încredere de aproape două decenii. VB Transform reunește oamenii care construiesc o strategie reală de inteligență artificială pentru companii. Află mai multe

Groq, startup-ul specializat în inferențe de inteligență artificială, face o mișcare agresivă pentru a provoca furnizori de cloud consacrați precum Servicii web Amazon şi Google cu două anunțuri majore care ar putea remodela modul în care dezvoltatorii accesează modele de inteligență artificială de înaltă performanță.

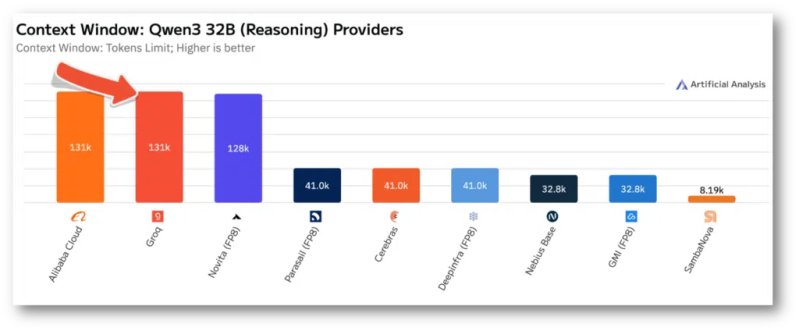

Compania a anunțat luni că oferă acum suport Modelul lingvistic Qwen3 32B al Alibaba cu fereastra sa completă de context de 131.000 de jetoane — o capacitate tehnică pe care susține că niciun alt furnizor de inferențe rapide nu o poate egala. Simultan, Groq a devenit un furnizor oficial de inferențe pe Platforma lui Hugging Face, expunând potențial tehnologia sa la milioane de dezvoltatori din întreaga lume.

Această mișcare este cea mai îndrăzneață încercare de până acum a Groq de a câștiga cotă de piață pe piața inferenței AI, aflată în rapidă expansiune, unde companii precum AWS Bedrock, Google Vertex AIși Microsoft Azure au dominat prin oferirea unui acces convenabil la modele lingvistice de top.

„Integrarea Hugging Face extinde ecosistemul Groq, oferind dezvoltatorilor opțiuni și reduce și mai mult barierele de intrare în adoptarea inferenței AI rapide și eficiente a Groq”, a declarat un purtător de cuvânt al Groq pentru VentureBeat. „Groq este singurul furnizor de inferențe care permite fereastra de context completă de 131K, permițând dezvoltatorilor să construiască aplicații la scară largă.”

Cum se compară afirmațiile Groq privind fereastra contextuală de 131k cu cele ale concurenților în inferență AI

Afirmația lui Groq despre ferestrele de context — cantitatea de text pe care un model de inteligență artificială o poate procesa simultan — lovește o limitare fundamentală care a afectat aplicațiile practice de inteligență artificială. Majoritatea furnizorilor de inferențe se luptă să mențină viteza și rentabilitatea atunci când gestionează ferestre de context mari, esențiale pentru sarcini precum analizarea documentelor întregi sau menținerea conversațiilor lungi.

Firmă independentă de benchmarking Analiză artificială a măsurat implementarea Qwen3 32B a Groq funcționând la aproximativ 535 de tokenuri pe secundă, o viteză care ar permite procesarea în timp real a documentelor lungi sau a sarcinilor complexe de raționament. Compania stabilește prețul serviciului la $0.29 pe milion de tokenuri de intrare și $0.59 pe milion de tokenuri de ieșire - tarife care subestează mulți furnizori consacrați.

„Groq oferă o stivă complet integrată, oferind calcule de inferență construite pentru scalabilitate, ceea ce înseamnă că suntem capabili să continuăm să îmbunătățim costurile de inferență, asigurând în același timp performanța de care dezvoltatorii au nevoie pentru a construi soluții reale de inteligență artificială”, a explicat purtătorul de cuvânt atunci când a fost întrebat despre viabilitatea economică a suportării ferestrelor de context masive.

Avantajul tehnic provine din personalizarea Groq Arhitectura unității de procesare a limbajului (LPU), conceput special pentru inferențe bazate pe inteligență artificială, mai degrabă decât pentru unitățile de procesare grafică (GPU) de uz general pe care se bazează majoritatea concurenților. Această abordare hardware specializată permite lui Groq să gestioneze mai eficient operațiunile care consumă multă memorie, cum ar fi ferestrele contextuale mari.

De ce integrarea Hugging Face a Groq ar putea debloca milioane de noi dezvoltatori de inteligență artificială

Cel/Cea/Cei/Cele integrare cu Hugging Face reprezintă probabil cea mai semnificativă mișcare strategică pe termen lung. Hugging Face a devenit platforma de facto pentru dezvoltarea de inteligență artificială open-source, găzduind sute de mii de modele și deservind milioane de dezvoltatori lunar. Devenind un furnizor oficial de inferențe, Groq obține acces la acest vast ecosistem de dezvoltatori cu facturare simplificată și acces unificat.

Dezvoltatorii pot acum selecta Groq ca furnizor direct în cadrul Loc de joacă pentru îmbrățișări faciale sau API-ul, cu facturarea utilizării în conturile lor Hugging Face. Integrarea acceptă o gamă largă de modele populare, inclusiv Meta Seria Lamă, Google Gemma models, și nou adăugatul Qwen3 32B.

„Această colaborare dintre Hugging Face și Groq reprezintă un pas semnificativ înainte în ceea ce privește creșterea accesibilității și eficienței inferenței bazate pe inteligența artificială de înaltă performanță”, se arată într-o declarație comună.

Parteneriatul ar putea crește dramatic baza de utilizatori și volumul tranzacțiilor Groq, dar ridică și semne de întrebare cu privire la capacitatea companiei de a menține performanța la scară largă.

Poate infrastructura Groq să concureze la scară largă cu AWS Bedrock și Google Vertex AI?

Când sunt întrebați despre planurile de extindere a infrastructurii pentru a gestiona trafic nou potențial semnificativ din partea Față îmbrățișătoarePurtătorul de cuvânt al Groq a dezvăluit amprenta globală actuală a companiei: „În prezent, infrastructura globală a Groq include centre de date în SUA, Canada și Orientul Mijlociu, care deservesc peste 20 de milioane de tokenuri pe secundă.”

Compania își propune să continue expansiunea internațională, deși nu au fost furnizate detalii specifice. Acest efort de scalare globală va fi crucial, deoarece Groq se confruntă cu o presiune tot mai mare din partea concurenților bine finanțați, cu resurse de infrastructură mai mari.

Amazon Serviciu de bază, de exemplu, valorifică infrastructura cloud globală masivă a AWS, în timp ce cea a Google Vertex AI beneficiază de rețeaua mondială de centre de date a gigantului de căutare. Microsoft Serviciul Azure OpenAI are o infrastructură la fel de profundă.

Cu toate acestea, purtătorul de cuvânt al Groq și-a exprimat încrederea în abordarea diferențiată a companiei: „Ca industrie, abia începem să vedem începutul unei cereri reale de calcul prin inferență. Chiar dacă Groq ar implementa dublul cantității planificate de infrastructură în acest an, tot nu ar exista suficientă capacitate pentru a satisface cererea de astăzi.”

Cum ar putea afecta modelul de afaceri al Groq prețurile agresive pentru inferența inteligenței artificiale

Piața de inferență a inteligenței artificiale a fost caracterizată de prețuri agresive și marje extrem de mici, deoarece furnizorii concurează pentru cota de piață. Prețurile competitive ale Groq ridică semne de întrebare cu privire la profitabilitatea pe termen lung, în special având în vedere natura intensivă în capital a dezvoltării și implementării hardware specializat.

„Pe măsură ce vedem tot mai multe soluții de inteligență artificială care apar pe piață și sunt adoptate, cererea de inferențe va continua să crească într-un ritm exponențial”, a declarat purtătorul de cuvânt când a fost întrebat despre calea către profitabilitate. „Scopul nostru final este să ne extindem pentru a satisface această cerere, valorificând infrastructura noastră pentru a reduce costul calculului prin inferențe cât mai scăzut posibil și pentru a facilita viitoarea economie bazată pe inteligență artificială.”

Această strategie — care pariază pe o creștere masivă a volumului pentru a obține profitabilitate în ciuda marjelor scăzute — reflectă abordările adoptate de alți furnizori de infrastructură, deși succesul este departe de a fi garantat.

Ce înseamnă adoptarea inteligenței artificiale la nivel de întreprindere pentru piața de inferențe de $154 miliarde

Anunțurile vin în contextul unei creșteri explozive a pieței de inferență a inteligenței artificiale. Firma de cercetare Grand View Research estimează că piața globală a cipurilor de inferență a inteligenței artificiale va ajunge la 14,154,9 miliarde de dolari până în 2030, impulsionată de implementarea tot mai mare a aplicațiilor de inteligență artificială în toate industriile.

Pentru factorii de decizie din mediul de afaceri, mișcările Groq reprezintă atât oportunități, cât și riscuri. Afirmațiile companiei privind performanța, dacă sunt validate la scară largă, ar putea reduce semnificativ costurile aplicațiilor bazate pe inteligență artificială. Cu toate acestea, dependența de un furnizor mai mic introduce, de asemenea, potențiale riscuri legate de lanțul de aprovizionare și continuitate în comparație cu giganții consacrați ai cloud-ului.

Capacitatea tehnică de a gestiona ferestre de context complet s-ar putea dovedi deosebit de valoroasă pentru aplicațiile enterprise care implică analiza documentelor, cercetare juridică sau sarcini complexe de raționament, unde menținerea contextului pe parcursul interacțiunilor lungi este crucială.

Anunțul dublu al Groq reprezintă un pariu calculat conform căruia hardware-ul specializat și prețurile competitive pot depăși avantajele de infrastructură ale giganților tehnologici. Succesul acestei strategii va depinde probabil de capacitatea companiei de a menține avantajele de performanță în timp ce se extinde la nivel global - o provocare care s-a dovedit dificilă pentru multe startup-uri de infrastructură.

Deocamdată, dezvoltatorii beneficiază de o altă opțiune de înaltă performanță pe o piață din ce în ce mai competitivă, în timp ce întreprinderile urmăresc dacă promisiunile tehnice ale Groq se traduc în servicii fiabile, de nivel de producție, la scară largă.