O nouă metodă a fost dezvoltată de laboratorul japonez de inteligență artificială Sakana AI care permite mai multor modele lingvistice mari (LLM) să lucreze împreună la o singură sarcină, creând efectiv o „echipă de vis” de agenți IA. Modelele pot face încercări și erori și își pot combina punctele forte distincte pentru a rezolva probleme care sunt prea dificile pentru orice unitate individuală folosind metoda, numită Multi-LLM AB-MCTS.

Această metodă oferă un mijloc de a crea sisteme de inteligență artificială mai puternice și adaptabile pentru companii. Companiile ar putea utiliza automat cele mai bune elemente ale diferitelor modele de frontieră, punând la punct inteligența artificială adecvată pentru sarcina potrivită, pentru a oferi rezultate superioare, în loc să fie limitate la un singur furnizor sau model.

Influența inteligenței sociale

Designurile Frontier AI sunt în continuă evoluție. Fiecare unitate, însă, are propriile avantaje și dezavantaje unice, fiecare dintre acestea derivând din propriile date de antrenament și arhitectură. Una poate excela la programare, în timp ce alta poate excela la scriere creativă. Aceste variații nu sunt un păianjen, ci o funcție, susțin cercetătorii de la Sakana AI.

Cercetătorii scriu în postarea de pe site-ul lor că „vedem aceste prejudecăți și abilități variate nu ca restricții, ci ca resurse valoroase pentru crearea unei inteligențe comune”. Ei cred că sistemele de inteligență artificială pot realiza mai mult prin colaborare, la fel cum cele mai mari realizări ale oamenilor pot fi atribuite diferitelor grupuri. Prin combinarea creierelor lor, sistemele de inteligență artificială pot rezolva probleme care sunt dincolo de raza de acțiune a oricărui model singular.

Gândește-te mai mult în timpul concluziei

Noul motor de la Sakana AI este o abordare de „scalare a timpului de inferență” (cunoscută și sub numele de „scalarea timpului de testare„, sau „scalarea timpului de testare„”, care a devenit foarte populară recent. Scalarea în timp de inferență îmbunătățește performanța prin distribuirea mai multor resurse de calcul după ce un model a fost antrenat, în timp ce majoritatea cercetărilor în domeniul inteligenței artificiale s-au concentrat pe „scalarea în timp de antrenament” (crearea de modele mai mari și antrenarea lor pe seturi de date mai mari).

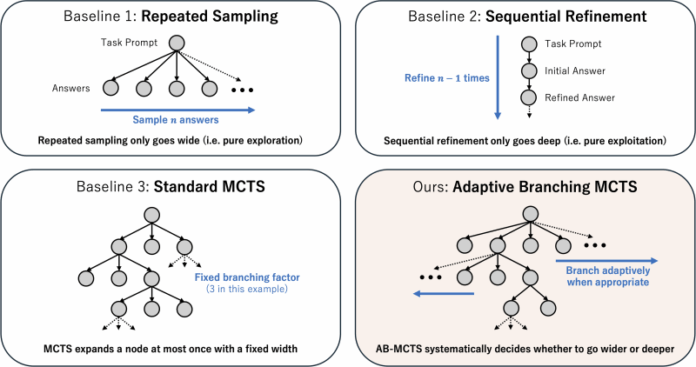

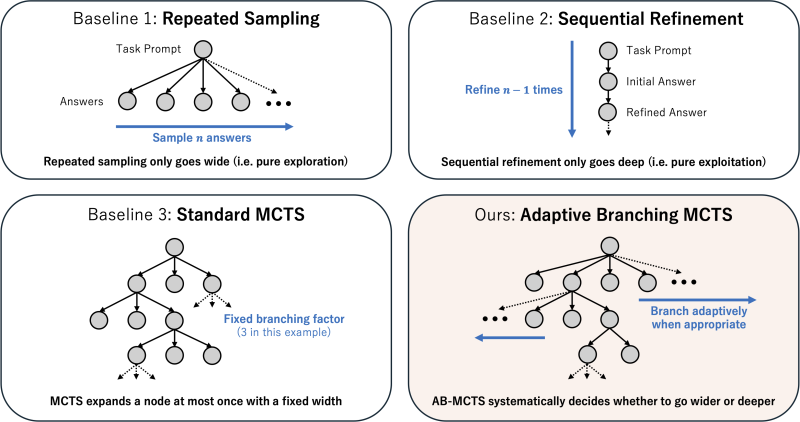

Așa cum se vede în modele populare precum OpenAI o3 și DeepSeek-R1, o abordare comună este utilizarea învățării prin consolidare pentru a determina modelele să genereze informații mai lungi și mai detaliate lanț de gânduri Secvențe (CoT). Eșantionarea repetată este o altă tehnică mai simplă, în care unității i se dă în mod repetat aceeași viteză pentru a veni cu o serie de răspunsuri posibile, similar unui program de brainstorming. Aceste idei sunt combinate și dezvoltate prin munca Sakana AI.

Potrivit lui Takuya Akiba, cercetător științific la Sakana AI și coautor al raportului, „fundația noastră oferă un tip mai inteligent și mai corporativ de Best-of-N (cunoscut și sub numele de repeated picking). Aceasta îmbunătățește strategiile logice, cum ar fi long CoT și RL, de exemplu. Această metodă maximizează performanța într-o cantitate limitată de apeluri LLM prin selectarea automată a strategiei de căutare și a LLM-ului corect, rezultând rezultate mai bune în sarcinile dificile.”

Cum funcționează căutarea responsivă prin dispersare

Un algoritm cunoscut sub numele de Adaptive Branching Monte Carlo Tree Search (AB-MCTS) formează fundamentul noii metode. Acesta permite unui LLM să efectueze cu succes încercări și erori prin echilibrarea eficientă a două tehnici distincte de căutare: „căutarea mai largă” și „căutarea mai profundă”. Căutarea mai profundă implică rafinarea constantă a unui răspuns tentant, în timp ce căutarea mai largă are ca rezultat crearea de răspunsuri complet noi din daune. Atunci când o idee bună ajunge la sfârșit, structura se poate articula și poate încerca ceva nou dacă ajunge într-un impas sau găsește o nouă direcție cu AB-MCTS.

Metoda folosește Căutare în arborele Monte Carlo (MCTS), un algoritm decizional bine-cunoscut utilizat de AlphaGo de la DeepMind, pentru a realiza acest lucru. AB-MCTS evaluează fiecare pas folosind modele probabilistice pentru a determina dacă este mai bine să se dezvolte o soluție nouă sau una existentă.

Investigația ulterioară a cercetătorilor, Multi-LLM AB-MCTS, decide „ce” să facă (rafinare vs. generare), precum și „care” LLM ar trebui să facă acest lucru. Sistemul nu este sigur ce tip este cel mai potrivit pentru problema de la începutul unei sarcini. Începe prin a încerca o combinație sănătoasă a LLM-urilor disponibile, apoi învață treptat care versiuni sunt mai puternice, oferind fiecăruia o sarcină mai mare în timp.

Examinarea „grupului de vis” al inteligenței artificiale

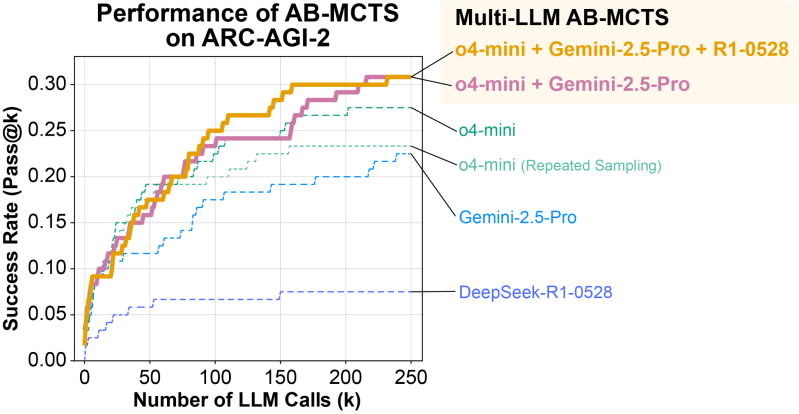

Oamenii de știință au testat programul Multi-LLM AB-MCTS folosind standardul ARC-AGI-2. ARC (Abstraction and Reasoning Corpus) este conceput pentru a testa capacitatea umană de a rezolva probleme noi de raționament vizual, ceea ce îl face extrem de dificil pentru inteligența artificială.

Echipajul a folosit o serie de modele de frontieră, inclusiv Gemeni 2.5 Pro, DeepSeek-R1 și o4-mini.

Peste 30 de dificultăți % din cele 120 de verificări au fost rezolvate de grupul de modele, ceea ce a fost considerabil mai mult decât orice model realizat de unul singur. Tehnica a demonstrat capacitatea de a selecta automat cel mai potrivit model pentru o anumită problemă. Motorul a identificat imediat cel mai eficient LLM și l-a folosit mai des în lucrările în care exista o cale clară către o alternativă.

Grupul a descoperit, de asemenea, situații în care proiectele au rezolvat probleme care anterior erau imposibile pentru oricare dintre ele, ceea ce este și mai impresionant. O soluție creată de modelul o4-mini a fost greșită într-un caz. Sistemul, însă, a încercat această soluție sub medie DeepSeek-R1 și Gemini-2.5 Pro, care au reușit să identifice defectul, să-l corecteze și, în cele din urmă, să găsească răspunsul corect.

Cercetătorii scriu: „Acest lucru arată că Multi-LLM AB-MCTS combină liber modele de frontieră pentru a rezolva probleme recent insolubile, împingând limitele a ceea ce se poate realiza prin utilizarea LLM-urilor ca inteligență socială.”

Înclinația spre halucinații poate diferi considerabil între modele, a spus Akiba, pe lângă avantajele și dezavantajele unice ale fiecăruia. Ce e mai bun din ambele lumi ar putea fi obținut prin crearea unui ansamblu cu un design care este mai puțin probabil să provoace halucinații, și anume abilități naturale solide și o bază solidă. Această abordare ar putea ajuta la atenuarea acesteia, deoarece halucinațiile reprezintă o problemă presantă în lumea afacerilor.

De la analiza teoretică la utilizări practice

Sakana AI a lansat motorul principal ca o fundație open-source numită TreeQuest, aplicabil în baza unui permis Apache 2.0 (utilizabil în scopuri comerciale). Pentru a ajuta dezvoltatorii și companiile să utilizeze această metodă, Sakana AI a lansat algoritmul principal ca un framework open-source numit TreeQuestCu ajutorul clasificării și logicii personalizate, utilizatorii pot folosi Multi-LLM AB-MCTS pentru propriile sarcini, utilizând API-ul versatil al TreeeQuest.

„Analiza noastră relevă un potențial semnificativ într-o serie de domenii”, a spus Akiba, „chiar dacă ne aflăm încă în stadiile incipiente ale aplicării AB-MCTS la anumite probleme orientate spre afaceri.”

Dincolo de standardul ARC-AGI-2, echipa a reușit să implementeze cu succes AB-MCTS pentru lucruri precum îmbunătățirea preciziei modelelor de învățare automată și provocarea programării algoritmice complexe.

„AB-MCTS ar putea fi, de asemenea, foarte eficient pentru problemele care necesită încercări iterative, cum ar fi creșterea indicatorilor de performanță ai aplicațiilor existente”, a spus Akiba. Ar putea fi utilizat, de exemplu, pentru a determina rapid modalități de creștere a costurilor de răspuns ale unui serviciu de rețea.

O nouă generație de aplicații de inteligență artificială pentru întreprinderi, mai puternice și mai fiabile, ar putea fi creată odată cu lansarea unui instrument open-source realist.